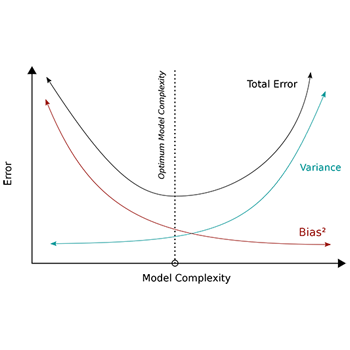

Bias Varianza

Bias e Varianza

Underfitting e Overfitting

bias

E' l'errore introdotto dal modello a causa di ipotesi semplificative errate o mancanti durante il processo di apprendimento.Un modello con alto bias tende a sottostimare la complessità dei dati, facendo previsioni troppo semplificate o errate.

varianza

La varianza, misura la sensibilità del modello alle variazioni nei dati di addestramento.Un modello con alta varianza è molto sensibile alle fluttuazioni nei dati di addestramento e può reagire in modo eccessivo ai rumori, generando previsioni instabili e non affidabili.

Underfitting

Underfitting si verifica quando il modello è troppo semplice per catturare la complessità dei dati.Questo è spesso associato a un bias elevato, in quanto il modello non è in grado di rappresentare adeguatamente la struttura sottostante dei dati, quindi le sue previsioni saranno inaffidabili e generalmente errate.

Overfitting

Overfitting, si verifica quando il modello è troppo complesso e si adatta troppo ai dati di addestramento, catturando anche il rumore nei dati. Ciò può portare a una varianza elevata, poiché il modello risponde eccessivamente alle fluttuazioni nei dati di addestramento, producendo previsioni molto precise sui dati di addestramento ma scadenti sul dati non visti.

In sintesi:

- underfitting è associato a un bias elevato

- overfitting è associato a una varianza elevata

Trovare un equilibrio tra bias e varianza è fondamentale per creare modelli di machine learning che generalizzino bene su nuovi dati.