Overfitting: Cause e Soluzioni

Quali sono le possibili soluzioni all' Overfitting

Cause Overfitting Reti Neurali

- Complessità del modello: Un modello con troppe reti nascoste, troppe strati o troppe connessioni rispetto alla complessità del problema può memorizzare il rumore nei dati anziché imparare i pattern significativi.

- Dimensione del dataset: Un dataset troppo piccolo può portare a un addestramento in cui il modello impara a memorizzare i dati piuttosto che a generalizzare da essi.

- Mancanza di dati di validazione: L'uso esclusivo dei dati di addestramento per valutare le prestazioni del modello può portare a una valutazione ottimistica delle prestazioni, poiché il modello può adattarsi troppo ai dati di addestramento senza essere in grado di generalizzare bene ai dati non visti.

- Feature selection: Se le feature selezionate non catturano in modo adeguato i pattern nei dati o se sono troppo correlate tra loro, il modello può avere difficoltà a generalizzare correttamente.

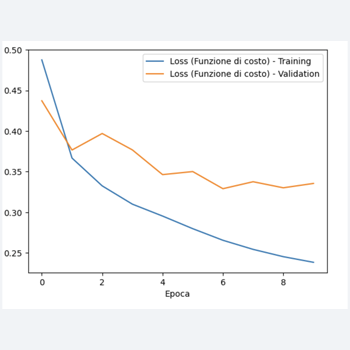

- Numero di epoche di addestramento:Addestrare il modello per un numero eccessivo di epoche può far sì che il modello memorizzi i dati di addestramento piuttosto che imparare da essi.

Questi sono solo alcuni dei principali fattori che possono contribuire all'overfitting in una rete neurale.

È importante comprendere questi fattori e utilizzare tecniche adeguate per mitigare l'overfitting durante il processo di addestramento del modello.

Possibili soluzioni all'Overfitting

Ecco alcune possibili soluzioni all'overfitting in una rete neurale.

- Riduzione della complessità del modello: Ridurre il numero di unità nascoste, il numero di strati o il numero di connessioni nel modello può ridurre la sua capacità di memorizzare i dati di addestramento e promuovere una migliore generalizzazione.

- Regolarizzazione: Utilizzare tecniche di regolarizzazione come la regolarizzazione L1 o L2, o l'aggiunta di dropout durante l'addestramento, può aiutare a prevenire l'overfitting limitando la complessità del modello e promuovendo una migliore generalizzazione.

- Cross-validation: Utilizzare tecniche di cross-validation per valutare le prestazioni del modello su dati non visti durante l'addestramento può aiutare a identificare e prevenire l'overfitting.

- Early stopping: Monitorare le prestazioni del modello sui dati di validazione durante l'addestramento e interrompere l'addestramento quando le prestazioni sul set di validazione iniziano a peggiorare può aiutare a prevenire l'overfitting.

- Aumento del dataset: Aumentare la dimensione del dataset mediante tecniche di aumento dei dati, come la rotazione, lo scambio, lo sfocatura, può aiutare il modello a imparare una migliore rappresentazione dei dati e ridurre l'overfitting.

- Feature : Effettuare una selezione o trasformazione delle feature può aiutare a ridurre la dimensione o la complessità dello spazio delle feature, contribuendo così a prevenire l'overfitting.

- Utilizzo di architetture più semplici: In alcuni casi, l'uso di architetture più semplici, come reti neurali poco profonde anziché reti neurali profonde, può essere sufficiente per ottenere buone prestazioni senza incorrere in problemi di overfitting.

Queste sono solo alcune delle possibili soluzioni all'overfitting in una rete neurale.

È importante esaminare attentamente il problema specifico e selezionare le tecniche di mitigazione dell'overfitting più appropriate in base alle caratteristiche del dataset e del modello.